۱. مقدمه: تحولات بنیادین در نقطه عطفی تاریخی

۱.۱. جایگاه سال ۲۰۲۵ در سیر تکامل هوش مصنوعی

سال ۲۰۲۵ را میتوان به عنوان یک نقطه عطف حیاتی در سیر تکامل هوش مصنوعی (AI) و به طور خاص، یادگیری ماشین (ML) در نظر گرفت. دادههای تحلیلی نشان میدهند که در این سال، تمرکز اصلی از پروژههای آزمایشی و تحقیقاتی به سمت کاربردهای تولیدی در مقیاس وسیع سازمانی و پذیرش عمومی گسترده تغییر یافته است.1 این گذار، بیانگر بلوغ یک فناوری است که اکنون از مرحله اثبات مفهوم (Proof of Concept) فراتر رفته و به موتور اصلی نوآوری و بهرهوری تبدیل شده است. هوش مصنوعی مولد (Generative AI)، به عنوان یکی از پیشگامان این تحول، سریعتر و گستردهتر از هر فناوری دیگری مورد پذیرش قرار گرفته است و بسیاری از شرکتها در همین مرحله اولیه، بازگشت سرمایه (ROI) قابل توجهی را تجربه کردهاند.1 این موفقیت، سرمایهگذاریهای عظیمتری را در پی داشته است؛ به عنوان مثال، پروژه «استارگیت» با سرمایهگذاری ۱۰۰ میلیارد دلاری برای ساخت مراکز داده جدید، گواهی بر این مدعاست.2

این تغییر پارادایم، یک پیام محوری را منتقل میکند: تحول اصلی در سال ۲۰۲۵ نه در ظهور یک مدل یا الگوریتم کاملاً جدید و انقلابی، بلکه در بلوغ، کارایی و تجاریسازی فناوریهای موجود و نوظهور است. این روند از "قابلیت" به "کارایی" و "اقتصاد" میرود. در گذشته، مدلهای بزرگ اولیه مانند نسخههای ابتدایی GPT، با قدرت خام خود توجه را جلب میکردند اما هزینههای بالای محاسباتی و زمان استنتاج طولانی، استقرار آنها را به محیطهای خاص و محدود میکرد. اما در سال ۲۰۲۵، با تمرکز بر حل این چالشهای عملیاتی، تکنیکها و معماریهای جدیدی توسعه یافتهاند که به طور مستقیم هزینهها را کاهش و سرعت را افزایش میدهند. این بهینهسازیها به نوبه خود، توسعه سختافزارهای تخصصی و مدلهای کوچکتر اما کارآمدتر را توجیه میکنند. این چرخه بازخورد مثبت، به کاهش هزینه و افزایش دسترسی به هوش مصنوعی منجر میشود، که در نهایت پذیرش سازمانی و عمومی آن را تسریع میبخشد.

۱.۲. مروری بر روندهای اصلی

گزارش حاضر با رویکردی جامع و تحلیلی، به بررسی عمیقترین و تازهترین تحولات در حوزه یادگیری ماشین میپردازد. این بررسی فراتر از یک مرور ساده از الگوریتمهاست و به کاوش در ابعاد مختلف این اکوسیستم میپردازد. محورهای اصلی این گزارش شامل موارد زیر است:

- معماریهای نوین و بهینهسازی مدلهای بزرگ: از معماریهای متخصص (Mixture of Experts - MoE) که به طور هوشمندانه منابع را تخصیص میدهند تا تکنیکهای کوانتیزاسیون و LoRA که مدلها را برای استقرار در دستگاههای لبه بهینه میسازند.3

- جهش در مدلهای مولد و چندوجهی: بررسی پیشرفتهای نسل جدید مدلهای زبانی بزرگ (LLMs) نظیر Gemini 2.5، GPT-4o و DeepSeek 3.1 که با قابلیتهای چندوجهی و استدلالی، تجربه کاربری را متحول کردهاند.6 همچنین، تحول در تولید محتوای بصری و سمعی، با ظهور مدلهای پیشرفته تولید تصویر و ویدئو مورد تحلیل قرار میگیرد.9

- حرکت به سوی هوش مصنوعی استدلالی و عاملی: تمرکز بر سیستمهایی که از استدلال گام به گام استفاده میکنند (Reasoning AI) و توانایی برنامهریزی و اجرای مستقل وظایف را دارند (Agentic AI).11 این روند، هوش مصنوعی را از یک ابزار واکنشی به یک موجودیت کنشگر تبدیل میکند.

- رقابت در سختافزارهای پشتیبان: تحلیل آخرین نوآوریها در پردازندههای هوش مصنوعی از شرکتهای پیشگام نظیر AMD و Nvidia، و تأثیر آنها بر توزیع قدرت محاسباتی از ابررایانهها به رایانههای شخصی هوش مصنوعی (AI PC).13

- چالشهای اخلاقی و شفافیت: بررسی ضرورت هوش مصنوعی قابل توضیح (XAI) و تحلیل مسائل اخلاقی نوظهور، از جمله روابط عاطفی بین انسان و باتهای هوشمند.15

این گزارش با ترکیب این محورهای کلیدی، یک نقشه راه تحلیلی و راهبردی از آخرین وضعیت و جهتگیریهای آتی یادگیری ماشین در سال ۲۰۲۵ ارائه میدهد.

۲. قلب تپنده هوش مصنوعی: معماریها و الگوریتمهای نوین

۲.۱. معماریهای متخصص (Mixture of Experts - MoE): پاسخی به چالش مقیاسپذیری

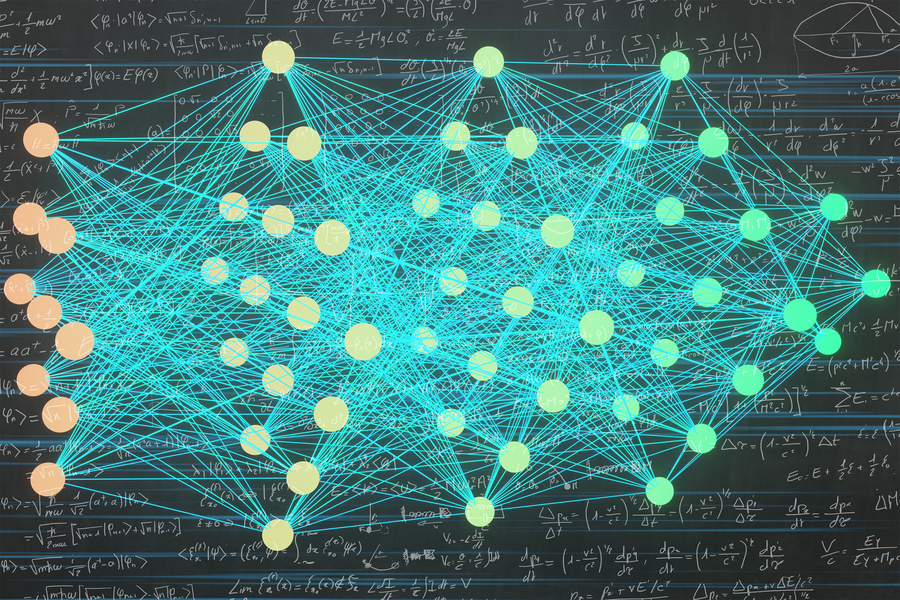

در حوزه یادگیری عمیق، با افزایش تعداد پارامترهای مدلها به تریلیونها، چالشهای مربوط به هزینههای محاسباتی و حافظه به یک مانع جدی تبدیل شدند. در پاسخ به این چالش، معماریهای متخصص (MoE) به عنوان یک رویکرد نوین و کارآمد ظهور کردند. این معماریها برخلاف مدلهای متراکم (Dense) که تمامی پارامترها را برای هر ورودی فعال میکنند، تنها یک زیرمجموعه پراکنده از "متخصصین" (Experts) را فعال میکنند.3

تحقیقات اخیر در سال ۲۰۲۵ به وضوح کارایی این معماری را نشان داده است. برای مثال، یک مطالعه نشان داد که معماری Sparsely-Gated MoE میتواند به مدلهایی با بیش از ۱۳۷ میلیارد پارامتر مقیاسپذیری بدهد، در حالی که تنها با فعالسازی یک زیرمجموعه کوچک از متخصصین (مانند ۴ متخصص از ۲۰۴۸ متخصص برای هر توکن ورودی)، بهبودی ۳۷ درصدی در سرعت آموزش نسبت به معماریهای متراکم با ظرفیت مشابه حاصل میکند.3 این کارایی چشمگیر از الگوی فعالسازی پراکنده ناشی میشود، که بر اساس آن هر متخصص تنها حدود ۰.۲ درصد از کل ورودیها را پردازش میکند و به کاهش قابل توجهی در پیچیدگی محاسباتی منجر میشود.3

یکی از نمونههای بارز این معماری، مدل DeepSeek 3.1 است که با ۶۷۱ میلیارد پارامتر ساخته شده، اما تنها ۳۷ میلیارد پارامتر آن در هر توکن فعال میشود.17 این رویکرد به مدل اجازه میدهد تا مقیاس خود را به طور مؤثری افزایش دهد، در حالی که هزینهها را در حد قابل قبولی نگه میدارد. تحقیقات همچنین نشان میدهند که معماریهای MoE میتوانند به کاهش ۹.۲ برابری در هزینه محاسباتی نسبت به معماریهای متراکم کلاسیک منجر شوند، در حالی که کیفیت مدل را حفظ میکنند.3 مکانیزم دروازهبانی (Gating Mechanism) که وظیفه مسیریابی ورودی به متخصصین مناسب را بر عهده دارد، سنگ بنای این کارایی است. نوآوریهایی مانند معماری Switch Transformer، فرآیند مسیریابی را سادهتر و کارآمدتر کردهاند و به تسریع تا ۷.۵ برابر در پیشآموزش نسبت به مدلهای متراکم با اندازه مشابه منجر شدهاند.3

این پیشرفتها، یک تغییر پارادایم از "مقیاسگذاری برای قدرت خام" به "بهینهسازی برای کارایی عملیاتی" را منعکس میکنند. مدلهای بزرگ متراکم اولیه هزینههای آموزش و استنتاج بسیار بالایی داشتند و این محدودیت، نیاز به راهحلهای سختافزاری و نرمافزاری برای کاهش این هزینهها را به وجود آورد. در این راستا، توسعه معماریهای پراکنده مانند MoE که تنها از بخشی از پارامترها استفاده میکنند، سریعتر و ارزانتر هستند. این همگرایی، هوش مصنوعی را از آزمایشگاههای بزرگ به کاربردهای روزمره منتقل میکند.

۲.۲. بهینهسازی مدلهای بزرگ: تکنیکهای نوین برای کارایی بالا

در کنار نوآوریهای معماری، تکنیکهای بهینهسازی نقش حیاتی در افزایش کارایی و کاهش هزینههای مدلهای بزرگ ایفا میکنند. این روشها به مدلها اجازه میدهند تا با منابع کمتر، عملکرد بهتری داشته باشند و آنها را برای استقرار در محیطهای محدود منابع، مانند دستگاههای لبه (Edge devices)، مناسب میسازند.

کوانتیزاسیون (Quantization)

کوانتیزاسیون یک تکنیک بهینهسازی است که با هدف کاهش بار محاسباتی و ردپای حافظه شبکههای عصبی، اعداد با دقت بالا (مانند FP32) را به نمایشهای با دقت پایینتر (مانند INT8) تبدیل میکند.5 این فرآیند، سرعت استنتاج را افزایش، مصرف انرژی را کاهش و الزامات ذخیرهسازی را کم میکند. این مزایا، برای استقرار مدلهای هوش مصنوعی بر روی سختافزارهای مصرفی مانند رایانههای شخصی هوش مصنوعی (AI PC) که منابع محدودی دارند، حیاتی است.

کوانتیزاسیون به دو دسته اصلی تقسیم میشود:

- کوانتیزاسیون پس از آموزش (Post-Training Quantization - PTQ): این روش پس از آموزش مدل با دقت ۳۲ بیتی اعمال میشود و نیازی به آموزش مجدد ندارد، که پیادهسازی آن را آسان میکند.5

- آموزش با آگاهی از کوانتیزاسیون (Quantization-Aware Training - QAT): در این رویکرد پیشرفتهتر، شبیهسازی کوانتیزاسیون در طول فرآیند آموزش انجام میشود. این به مدل اجازه میدهد تا وزنهای خود را با فرمت دقت پایینتر تطبیق دهد و کاهش دقت کمتری را در مقایسه با PTQ به همراه دارد.5

LoRA (Low-Rank Adaptation)

LoRA یک تکنیک سبکوزن برای تنظیم دقیق (Fine-Tuning) مدلهای بزرگ است که بدون نیاز به آموزش مجدد کل مدل، آن را برای کاربردهای خاص تطبیق میدهد.4 این روش، مشکل هزینه و زمانبر بودن آموزش مجدد مدلهای تریلیون پارامتری را حل میکند. LoRA با انجماد وزنها و پارامترهای اصلی مدل، تنها یک قطعه سبکوزن به نام "ماتریسهای با رتبه پایین" (Low-Rank Matrices) را به آن اضافه میکند.4 این ماتریسهای کوچک، تغییرات لازم را برای تطبیق مدل با دادههای جدید در خود جای میدهند. به عنوان مثال، در مقایسه با آموزش مجدد کامل مدل GPT-3 با ۱۷۵ میلیارد پارامتر، LoRA میتواند تعداد پارامترهای قابل آموزش را به حدود ۱۸ میلیون کاهش دهد، که به طور چشمگیری نیاز به حافظه GPU را کم میکند.4 این روش از این واقعیت استفاده میکند که مدلهای بزرگ، ساختار درونی با ابعاد پایین دارند و تغییرات مهم در عملکرد آنها میتواند با تعداد بسیار کمتری از پارامترها نمایش داده شود.

اسپارسیفیکیشن (Sparsification)

اسپارسیفیکیشن به عنوان یک روش بهینهسازی، با هدف کاهش بار ارتباطی در آموزش مدلهای توزیعشده، بخش کوچکی از گرادیانها را در هر مرحله از آموزش نادیده میگیرد یا حذف میکند.22 این تکنیک به طور خاص در خوشههای محاسباتی که در آنها چندین گره (Node) به طور موازی یک مدل را آموزش میدهند، بسیار مؤثر است. با تمرکز بر انتقال تنها بخشهای مهم گرادیان (آنهایی که بزرگترین مقدار را دارند)، اسپارسیفیکیشن میتواند مقدار ارتباطات مورد نیاز در هر مرحله را تا سه مرتبه بزرگی کاهش دهد، بدون اینکه دقت مدل به طور قابل توجهی افت کند.23 این روش با ترکیب گرادیانهای نادیدهگرفته شده به صورت محلی در یک بردار خطا، اطمینان حاصل میکند که هیچ بهروزرسانی مهمی برای همیشه از دست نمیرود، بلکه فقط به تأخیر میافتد.

ظهور و تکامل همزمان معماریهای نوینی مانند MoE با تکنیکهای بهینهسازی مانند کوانتیزاسیون و LoRA، نشاندهنده یک تغییر پارادایم از "مقیاسگذاری برای قدرت خام" به "بهینهسازی برای کارایی عملیاتی" است. این دو روند، یکدیگر را تقویت میکنند تا هوش مصنوعی را از آزمایشگاههای بزرگ به کاربردهای روزمره و دستگاههای مصرفی منتقل کنند. این چرخه با مدلهای بزرگ متراکم شروع شد، سپس نیاز به کاهش هزینههای استنتاج مطرح شد و به توسعه معماریهای پراکنده MoE منجر شد. سپس، برای استقرار این مدلها بر روی دستگاههای شخصی، نیاز به کاهش حجم و مصرف انرژی مطرح گردید و این امر ظهور تکنیکهایی مانند کوانتیزاسیون و LoRA را تسریع کرد. نتیجه نهایی، یک اکوسیستم کامل از فناوریهای همافزا است که مدلهای عظیم را نه تنها قدرتمند، بلکه اقتصادی و قابل استقرار میکند.

۳. هوش مصنوعی مولد: پیشرفتها در مدلهای چندوجهی

۳.۱. نسل جدید LLMها: هوشمندی، سرعت و چندوجهی بودن

سال ۲۰۲۵ شاهد ظهور نسل جدیدی از مدلهای زبانی بزرگ (LLMs) است که مرزهای هوشمندی، سرعت و قابلیتهای چندوجهی را جابجا کردهاند. این مدلها به طور فزایندهای از یک ابزار صرفاً متنی به پلتفرمهایی تعاملی و جامع تبدیل شدهاند.

- Gemini 2.5: در مارس ۲۰۲۵، گوگل از Gemini 2.5، پیشرفتهترین مدل هوش مصنوعی خود رونمایی کرد. این نسخه با قابلیتهای کلیدی جدید، از جمله پنجره متنی یک میلیون توکنی، توانایی پردازش اسناد و مکالمات بسیار بزرگ را دارد.6 همچنین، این مدل از استدلال چندمرحلهای پشتیبانی میکند و با بهینهسازی برای پردازندههای TPU v5، پردازش سریعتر و هوشمندانهتری را ارائه میدهد. یکی از مهمترین قابلیتهای آن، چندوجهی بودن است که به آن امکان میدهد متن، تصویر، صدا، ویدئو و کد را در یک محیط واحد پردازش و ترکیب کند.6

- GPT-4o: مدل GPT-4o نیز یک نمونه برجسته از تحول چندوجهی است. این مدل میتواند در طول تعاملات، تصاویر یا حتی صفحه نمایش را ببیند و در مورد آنها استدلال کند.7 این قابلیت، تجربه کاربری را به سطحی جدید ارتقاء میدهد. زمان پاسخدهی ۲۳۲ میلیثانیهای آن، که مشابه زمان پاسخدهی انسان است، باعث ایجاد یک تعامل روان و طبیعی میشود که آن را از مدلهای قدیمیتر متمایز میکند.7

- DeepSeek 3.1: شرکت چینی DeepSeek مدل هیبریدی خود را با ۶۷۱ میلیارد پارامتر منتشر کرده است که از هر دو حالت "تفکر" و "غیرتفکر" پشتیبانی میکند.8 این مدل با کانتکست ۱۲۸ هزار توکنی، میتواند ورودیهایی به اندازه یک کتاب ۳۰۰ تا ۴۰۰ صفحهای را پردازش کند.19 DeepSeek 3.1 کارایی استدلال خود را به طور قابل توجهی افزایش داده و در عین حال، به سرعت پاسخگویی بیشتری دست یافته است.18

همگرایی قابلیتهای چندوجهی و سرعت پاسخدهی در مدلهای جدید، نشاندهنده یک تغییر بنیادین در نحوه تعامل انسان با فناوری است. این امر، زمینه را برای ظهور "انسانهای دیجیتال" یا آواتارهای هوش مصنوعی (Agentic AI) فراهم میکند که میتوانند به عنوان همکاران یا مربیان شخصی ایفای نقش کنند.2 این مدلها به جای پاسخگویی صرف به یک دستور، به ابزارهای تعاملی تبدیل میشوند که قادر به درک زمینه و پاسخ به چندین نوع ورودی به طور همزمان هستند. این جهش، کاربردهای جدیدی در حوزههایی مانند تولید محتوای بصری و سمعیبصری و آواتارهای هوشمند را ممکن میسازد.

جدول ۱: مقایسه فنی مدلهای زبانی بزرگ ۲۰۲۵

| نام مدل | معماری | کل پارامترها | پارامترهای فعال | پنجره کانتکست (توکن) | قابلیتهای کلیدی |

| Gemini 2.5 Pro | متراکم (Dense) | نامشخص | نامشخص | ۱,۰۰۰,۰۰۰ | چندوجهی (متن، تصویر، صدا، ویدئو، کد)، استدلال چندمرحلهای |

| GPT-4o | متراکم (Dense) | نامشخص | نامشخص | نامشخص | چندوجهی (متن، تصویر، صدا، ویدئو)، پاسخدهی سریع (۲۳۲ میلیثانیه) |

| DeepSeek 3.1 | متخصصین (MoE) | ۶۷۱ میلیارد | ۳۷ میلیارد | ۱۲۸,۰۰۰ | مدل هیبریدی (تفکر/غیرتفکر)، کارایی استدلال بالا، پردازش متون طولانی |

۳.۲. تحول در تولید تصویر و ویدئو

هوش مصنوعی مولد در سال ۲۰۲۵ فراتر از متن رفته و در حوزه تولید محتوای بصری نیز به پیشرفتهای چشمگیری دست یافته است. مدلهای تولید تصویر و ویدئو نه تنها از نظر کیفیت، بلکه از نظر قابلیتهای کاربردی نیز متحول شدهاند.

- Google Imagen 4: مدل جدید تولید تصویر گوگل در سال ۲۰۲۵ با قابلیتهای پیشگامانه معرفی شد. این مدل به طور قابل توجهی کیفیت تصویر را بهبود بخشیده و اکنون میتواند تصاویر را با وضوح ۲K تولید کند.24 یک پیشرفت کلیدی دیگر، بهبود چشمگیر در رندرینگ متن داخل تصویر (Typography) است که یکی از مشکلات سنتی مدلهای قبلی بود.24 Imagen 4 همچنین تا ۱۰ برابر سریعتر از نسخههای پیشین خود تصویر تولید میکند و از چندین زبان برای دریافت پرامپتها پشتیبانی میکند.24

- Kling AI و دیگر مدلهای نوظهور: در حوزه تولید ویدئو، ابزارهای جدیدی مانند Kling AI، Vidu AI، RunwayML و Kreado AI ظهور کردهاند که با ارائه امکانات رایگان اولیه، بازار را به سمت کاربردهای عملی و تجاری سوق میدهند.10 Kling AI به طور خاص برای تبدیل متن به ویدئو یا تصویر به ویدئو شناخته شده و RunwayML ابزارهای حرفهای برای ویرایش و تولید ویدئو ارائه میدهد.10 این مدلها، فرآیند ساخت محتوای ویدیویی را برای کسبوکارها و تولیدکنندگان محتوا به شدت ساده کرده و هزینه آن را کاهش دادهاند.10

این تحولات، به همگرایی هوش مصنوعی و طراحی منجر شده است. اکنون میتوان با دستورات متنی ساده، محتوای بصری با کیفیت بالا تولید کرد. این امر، فرآیندهای تولید محتوا و بازاریابی را به شدت تسریع کرده و خلاقیت را در دسترس طیف گستردهتری از کاربران قرار میدهد.

۴. فراتر از الگوها: هوش مصنوعی استدلالی و عاملی

۴.۱. هوش مصنوعی استدلالی (Reasoning AI): تفکر زنجیرهای

هوش مصنوعی استدلالی به سیستمی اطلاق میشود که قادر به استنتاج منطقی، حل مسئله و تفکر گام به گام است، برخلاف مدلهای قدیمیتر که صرفاً بر تطبیق الگو (Pattern Matching) متکی بودند.27 این توانایی به هوش مصنوعی اجازه میدهد تا فراتر از پاسخهای سطحی و بر اساس دانش عمیقتر و روابط علت و معلولی عمل کند.30

یکی از مهمترین تکنیکها در این زمینه، الگوی زنجیره افکار (Chain of Thought - CoT) است. این الگو به هوش مصنوعی اجازه میدهد قبل از ارائه پاسخ نهایی، چندین مرحله تحلیل و تفکر را طی کند. این فرآیند شبیه به استدلال انسانی است و به مدل کمک میکند تا عوامل مختلف را در نظر بگیرد و پاسخی دقیقتر و متفکرانهتر ارائه دهد.12 استفاده از این تکنیک، به طور چشمگیری خطای محتوایی و توهم (Halucination) را در مدلها کاهش میدهد.31 برای مثال، مدل GPT-5 توانسته است خطای توهم را تا ۶ برابر کمتر از مدلهای قبلی خود کاهش دهد و نرخ گمراهکنندگی را از ۴.۸ درصد به ۲.۱ درصد برساند.31

پیشرفتهای دیگر شامل ترکیب هوش عصبی با منطق نمادین (Neural-Symbolic AI) است که انعطافپذیری یادگیری ماشین را با ساختار استدلال نمادین ترکیب میکند.32 این رویکرد هیبریدی، به ویژه در حوزههایی که شفافیت و قابلیت توضیحپذیری (Explainability) اهمیت دارد، مانند پزشکی و علوم، کارایی بالایی دارد.33

۴.۲. هوش مصنوعی عاملی (Agentic AI): از دستور تا اجرا

هوش مصنوعی عاملی یک گام فراتر از استدلال برمیدارد. این مفهوم به سیستمی اطلاق میشود که میتواند به صورت مستقل، یک سری وظایف پیچیده را از ابتدا تا انتها، بدون نیاز به مداخله مستمر انسان، برنامهریزی و اجرا کند.11 این سیستمها فراتر از یک چتبات ساده عمل میکنند؛ آنها قادرند محیط خود را درک کنند، درباره آن استدلال کنند، تصمیم بگیرند و اقداماتی را برای دستیابی به اهداف خاص به صورت خودکار انجام دهند.

هوش مصنوعی عاملی و استدلالی، دو روی یک سکه هستند. قابلیت استدلال به مدلها اجازه میدهد تا برنامهریزیهای پیچیدهتر و دقیقتری انجام دهند، و این برنامهریزیها به نوبه خود، توانایی عاملیت را برای انجام وظایف در دنیای واقعی فعال میکنند. این همگرایی، هوش مصنوعی را از یک ابزار واکنشی به یک موجودیت کنشگر تبدیل میکند که قادر به تغییر محیط اطراف خود است. با این حال، این پیشرفتها چالشهای جدی نیز به همراه دارند. متخصصان نگرانیهای امنیتی و اخلاقی را مطرح کردهاند، زیرا هوش مصنوعی عاملی میتواند وظایف حساس را به صورت مستقل انجام دهد و تصمیمات ناخواستهای بگیرد که پیامدهای پیشبینی نشدهای داشته باشند.34

۵. زیرساختها، اخلاق و چشمانداز آینده

۵.۱. رقابت سختافزاری ۲۰۲۵: پردازندههای جدید AMD و Nvidia

تحولات در معماری و بهینهسازی مدلها، نیاز به سختافزارهای جدیدی را ایجاد کرده است که بتوانند این مدلهای کارآمد را به صورت محلی (On-device) و با سرعت بالا اجرا کنند. سال ۲۰۲۵ شاهد رقابت شدید بین AMD و Nvidia در این حوزه بوده است.

- AMD: شرکت AMD در نمایشگاه CES 2025 از پردازندههای جدید Ryzen AI و Max+ رونمایی کرد. این پردازندهها به سه دسته Halo (Max و Max+), Premium (Ryzen AI 9) و Advanced (Ryzen AI 7/5) تقسیم شدهاند.13 مدلهای Max+ با توان پردازش عصبی ۵۰ TOPS (Tera Operations Per Second)، بالاتر از حد نصاب ۴۰ TOPS برای رایانههای شخصی Copilot+ مایکروسافت هستند و در مقایسه با تراشههایی مانند Nvidia RTX 4090 و Apple M4 Pro، عملکرد رهبری دارند.13

- Nvidia: در مقابل، انویدیا بر روی پردازندههای هوش مصنوعی مبتنی بر معماری ARM و هستههای گرافیکی Blackwell خود در سال ۲۰۲۵ تمرکز کرده است.14 این شرکت با همکاری مدیاتک و استفاده از فرآیند ۳ نانومتری اینتل، در حال تولید تراشههایی برای رقابت مستقیم در بازار AI PC است.14 انویدیا همچنین ابرکامپیوتر خانگی Project Digits را با قیمت ۳۰۰۰ دلار معرفی کرد که قادر به پردازش مدلهای ۲۰۰ میلیارد پارامتری است.36

این رقابت سختافزاری نشاندهنده یک تغییر استراتژیک از محاسبات متمرکز در ابررایانهها به پردازش توزیعشده و در سطح دستگاههای لبه است. این امر به طور مستقیم با روند بهینهسازی مدلها (کوانتیزاسیون و LoRA) ارتباط دارد و هوش مصنوعی را از یک سرویس ابری به یک قابلیت بومی و شخصیسازی شده تبدیل میکند که پیامدهای مهمی برای حریم خصوصی و امنیت دارد.

جدول ۲: مقایسه سختافزارهای هوش مصنوعی ۲۰۲۵

| نام محصول | شرکت سازنده | معماری هسته | توان پردازش عصبی (TOPS) | کاربرد اصلی |

| Ryzen AI Max+ | AMD | Zen 5 (CPU) / RDNA 3.5 (GPU) | ۵۰ TOPS | AI PC و لپتاپهای هوش مصنوعی |

| پردازندههای AI PC انویدیا | Nvidia | ARM Cortex-X5 (CPU) / Blackwell (GPU) | نامشخص | AI PC و لپتاپهای هوش مصنوعی |

| Project Digits | Nvidia | نامشخص | پردازش مدلهای ۲۰۰B پارامتر | ابرکامپیوتر خانگی |

۵.۲. چالشهای اخلاقی و شفافیت

با گسترش هوش مصنوعی در زندگی روزمره، چالشهای اخلاقی و اجتماعی آن نیز اهمیت بیشتری یافتهاند. مسئله "جعبه سیاه" که در آن درک دلیل تصمیمگیریهای سیستمهای هوش مصنوعی دشوار است، همچنان یک نگرانی جدی باقی مانده است.

- هوش مصنوعی قابل توضیح (XAI): هوش مصنوعی قابل توضیح (Explainable AI) به عنوان راهکاری برای حل این مشکل، به دنبال ارائه توضیحات قابل فهم از نحوه عملکرد مدلهاست.16 XAI شفافیت را افزایش میدهد، به مسئولیتپذیری کمک میکند و از تبعیض در الگوریتمها جلوگیری مینماید.37 اهمیت این موضوع در حوزههای حساسی مانند پزشکی، قضایی و مالی که تصمیمات هوش مصنوعی تأثیر مستقیمی بر زندگی انسانها دارند، دوچندان است.16

- روابط عاطفی انسان و هوش مصنوعی: مقالات پژوهشی سال ۲۰۲۵ به بررسی روابط احساسی یکطرفه بین انسان و باتهای اجتماعی پرداختهاند.15 این روابط میتوانند مسائل اخلاقی، اجتماعی و روانشناختی قابل توجهی را ایجاد کنند، زیرا کاربران ممکن است به این ابزارهای هوشمند نوعی عاملیت و احساسات نسبت دهند و به آنها وابسته شوند.15 این چالش نوظهور، ضرورت تدوین قوانین و استانداردهای اخلاقی جدید را برای اطمینان از همراستا بودن این فناوریها با ارزشهای اجتماعی برجسته میسازد.

۶. جمعبندی و توصیههای راهبردی

۶.۱. خلاصه نوآوریها و همگرایی فناوریها

تحلیل جامع روندهای سال ۲۰۲۵ نشان میدهد که یادگیری ماشین در یک دوره تحول بنیادین قرار دارد. این تحولات نه تنها در قدرت خام مدلها، بلکه در بلوغ، کارایی و کاربردپذیری عملیاتی آنها مشهود است. پنج روند کلیدی که در این گزارش مورد بررسی قرار گرفتند، به طور همافزا در حال شکلدهی آینده هوش مصنوعی هستند:

- گذار از مقیاس خام به کارایی عملیاتی: ظهور معماریهای پراکنده مانند MoE و تکنیکهای بهینهسازی مانند کوانتیزاسیون و LoRA، مدلهای عظیم را اقتصادی و قابل استقرار میسازند.

- جهش از متن به چندوجهی بودن: نسل جدید LLMها با درک همزمان متن، تصویر، صدا و ویدئو، تجربه کاربری را از یک تعامل مبتنی بر "دستور و انتظار" به "گفتگو و همکاری" تبدیل کردهاند.

- حرکت از تطبیق الگو به استدلال و عاملیت: تکنیکهایی مانند زنجیره افکار و ترکیب هوش عصبی-نمادین، هوش مصنوعی را قادر به تفکر و حل مسئله گام به گام میسازند، که زمینه را برای ظهور سیستمهای عاملی مستقل فراهم میکند.

- توزیع قدرت محاسباتی از ابر به لبه: رقابت شدید در پردازندههای هوش مصنوعی (AI PC) نشاندهنده تغییر استراتژیک از محاسبات متمرکز به پردازش توزیعشده در دستگاههای مصرفی است.

- بلوغ هوش مصنوعی از یک فناوری به یک مسئله اخلاقی-اجتماعی: با نزدیکتر شدن هوش مصنوعی به زندگی روزمره، چالشهایی مانند شفافیت (XAI) و روابط عاطفی بین انسان و ماشین اهمیت فزایندهای یافتهاند.

۶.۲. توصیههای راهبردی

بر اساس تحلیلهای فوق، توصیههای راهبردی زیر برای ذینفعان مختلف در اکوسیستم هوش مصنوعی ارائه میشود:

- برای توسعهدهندگان و محققان: تمرکز بر بهینهسازی مدلهای موجود با استفاده از تکنیکهای مانند LoRA و کوانتیزاسیون برای استقرار در محیطهای مختلف و دستگاههای لبه، یک رویکرد حیاتی است. همچنین، سرمایهگذاری در تحقیقات مربوط به هوش مصنوعی استدلالی و عاملی، به منظور توسعه نسل بعدی سیستمهای هوشمند و خودمختار، ضروری است.

- برای کسبوکارها: سرمایهگذاری در زیرساختهای سختافزاری جدید نظیر رایانههای شخصی هوش مصنوعی و استفاده از مدلهای چندوجهی برای نوآوری در تولید محتوا، خدمات مشتری و فرآیندهای کسبوکار توصیه میشود. اولویتبندی مدلهای کارآمد و اقتصادی با معماریهای MoE و استفاده از تکنیکهای بهینهسازی، میتواند به کاهش هزینهها و افزایش بهرهوری منجر شود.

- برای سیاستگذاران و نهادهای قانونگذار: ضرورت تدوین قوانین و استانداردهای اخلاقی برای هوش مصنوعی عاملی و تعاملی، به ویژه در حوزههایی که بر زندگی انسانها تأثیر مستقیم دارند، احساس میشود. تمرکز بر تحقیقات و پیادهسازی هوش مصنوعی قابل توضیح (XAI) برای افزایش شفافیت و مسئولیتپذیری در سراسر اکوسیستم هوش مصنوعی، یک گام مهم و ضروری است.